一、什么是智能座舱与多模态交互

1. 什么是智能座舱

“智能座舱”目前还没有一个统一的定义,它的概念本身一直随着外界环境的发展而不断变化着。跟传统座舱相比,智能座舱的“智能”主要体现在以下几个方面:

- 仪式感:App远程控制、车门迎宾灯+交互式大灯、智能形象+语音欢迎语等;

- 科技性:ADAS驾驶辅助、高精地图、智能导航、驾驶员疲劳监测、主动调节驾驶坐姿等;

- 易用性:多屏互联(中控屏、副驾驶娱乐屏、仪表盘、HUD)、智能语音、多模交互等;

- 安全感:底盘操控、驾乘品质感、先进技术加持等;

- 人性化:模式调节、自动泊车、寻找充电桩、自动充电等;

- 第三空间:沉浸式座舱、k歌模式、智能游戏、社交互联等。

二、什么是多模态交互

“模态”(modality)一词是由德国生理学赫尔姆霍兹提出的生物学概念,即生物凭借感知器官与经验来接收信息的通道,例如人类可以通过五感来获取外界信息。“多模态交互”就是融合了人的视觉、听觉、触觉等多种感官,计算机利用多种通信通道响应输入,并充分模拟人与人之间的交互方式。

二、智能座舱中常见的模态有哪些?

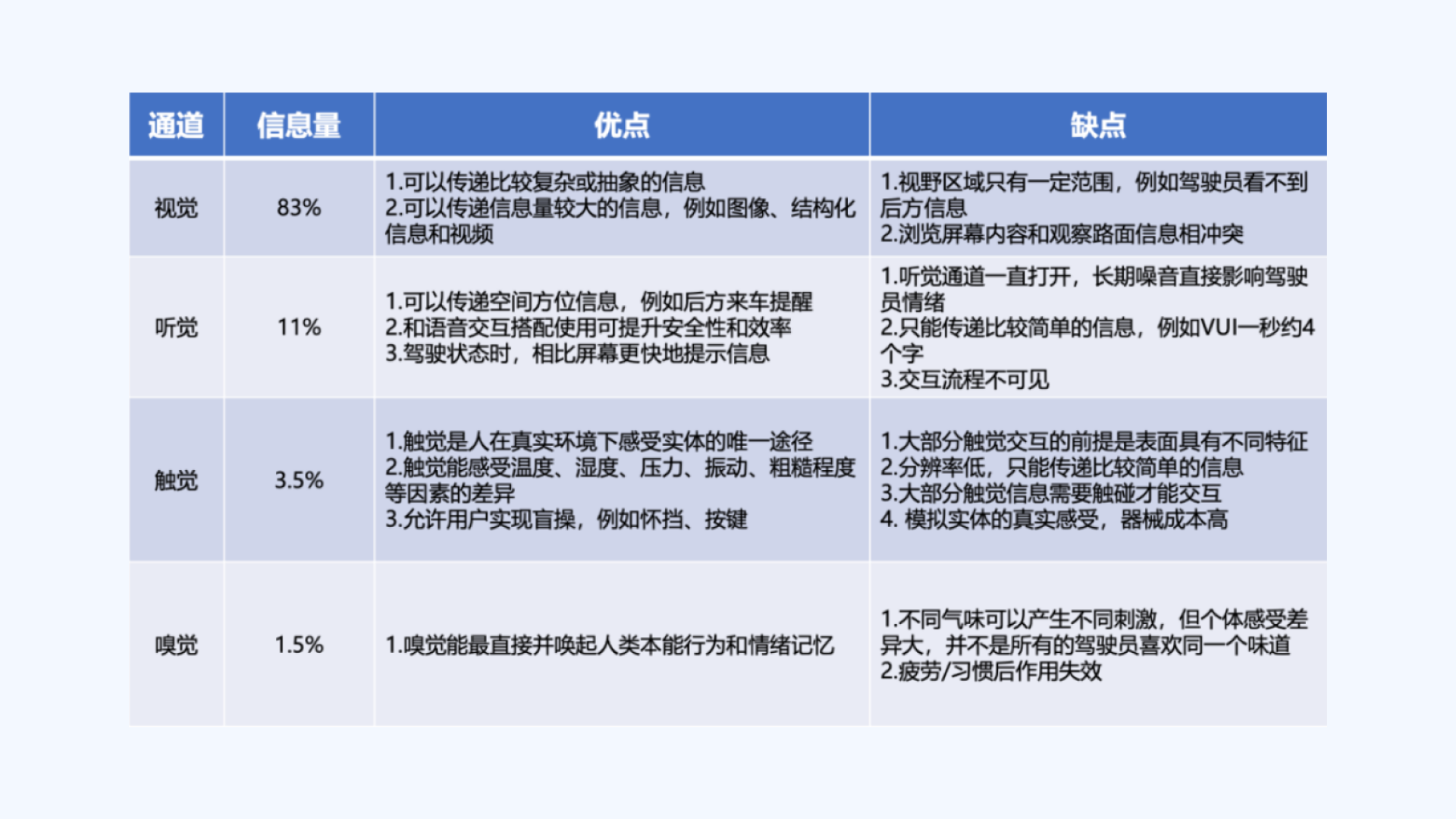

目前智能座舱的模态包括视觉、听觉、触觉、手势和嗅觉,以下将会分别介绍这几个模态在智能座舱中对应的载体有哪些

视觉:HUD+仪表盘+中控+后视镜+氛围灯

听觉:音乐+语音交互+警示音

触觉:方向盘+按键+中控+挡位+座椅+安全带更多用于提示场景

手势:隔空控制音量、切换歌曲、控制车窗等场景

嗅觉:不同气味用于不同场景,疲劳场景可用于提神 (理想L9)

三、智能座舱常见模态的优缺点

整个智能座舱的大部分的信息都放在视觉通道里面,这无疑会增加驾驶员的认知负荷,单模态交互难以满足复杂的驾驶场景,各模块彼此间的关联性不强,大大降低了信息感知的价值。

如何实现高效、安全、易用的人机交互,避免驾驶员注意力分散,降低交互认知和改善人车交互体验是值得思考的问题。

因此,这也是接下来要讨论的多模态的交互如何改善驾驶过程的安全与效率。

四、智能座舱为什么需要多模态交互

经研究表明,人类更习惯多模态交互,尤其高优先级消息以多模态的冗余增益可以加快处理时间,例如视觉+听觉或视觉+振动触觉警告比单模警告拥有更快响应。

以下将️通过【多重资源理论】和【态势感知】两个模型来进行分析

多重资源理论:一个通道接收的信息是有上限的,当信息过载时,会导致人的认知负荷,从而降低效率。为了避免视觉通道超负荷,可以将部分信息通过听觉通道呈现,这能有效降低司机的工作负荷。

态势感知:态势感知(Situation Awareness,SA)是一种感受者根据环境因素而动态、整体地理解当前情境的能力,由此可以提升对安全风险的发现识别、理解分析及响应能力,以便于做出最终的决策与行动。

对于新手司机来说,在驾驶过程当中,会比较关注路面,这时候如果在视觉上弹出信息,就很容易造成他们的注意力分散,这就是态势感知的丧失。这时如果通过语音或者触觉的通道去反馈,可以保证驾驶员注意力不被分散,从而也提高了安全性和效率。

智能座舱多模态交互的重要性

对驾驶员行为和状态进行多模监测

通过对方向盘的转向,行驶轨迹,油门的加减速,以及视觉摄像头的分析,可以判断驾驶员是否在开启ADAS系统后,处于瞌睡、疲劳、分心等脱离驾驶状态中。

多模提示让驾驶员保持良好的态势感知

当车辆开启ACC(Adaptive Cruise Control,ACC)功能时,车辆监测车外环境,包括其他车辆的运动状态、特定工况等,结合车内动态信息显示在AR-HUD上,比如当下时速、车距、基本车辆信息,帮助驾驶员判断前车运动轨迹,增强态势感知,降低驾驶员工作负荷,及时作出有效判断及行动。

五、智能座舱多模态交互的应用

1. 语音+视觉

语音交互在实际应用中本身是不可见的东西,如果不与视觉模态进行融合,驾驶员很难预判出他们发出的指令处于哪个状态,从而失去把控感。比如在进行语音命令时,它产生的状态有:唤醒-聆听-识别-播报-持续倾听,通过中控屏幕上的语音虚拟形象或者实体机器人的空间方位和状态来区别不同阶段,可以提高驾驶员的安全感。

2. 视觉+触觉

小鹏P7打开车道辅助时,为了减少驾驶员在开车时低头看仪表盘,方向盘会通过抖动的方式来提示目前车辆压线了;另外,还可以通过方向盘的物理按键唤醒语音,语音虚拟形象的状态变化显示在中控屏上。

除了常规的多模态交互以外,在广义的模态交互还包括了什么?

- 通过面部特征识别分析当前驾驶者的坐姿设置,自动调节座椅和方向盘高度

- 通过眼动追踪、心电、呼吸特征监测驾驶者是否疲劳、身体异常、分神等异常情况,进行多模态警示,来保障驾驶者的安全

六、多模态交互面临的挑战

1. 不同模态的识别精度有待提高

眼动追踪在短期内精度无法再提高,这容易导致AR-HUD贴合和疲劳检测出现部分问题。

2. 不同模态融合准确率有待提高

以分神驾驶为例,眼动追踪、头部追踪、方向盘旋转角度、道路偏移等参数整合时存在一定的不客观性(环境因素、个体差异等等)。

3. 多模态识别需要的算力在目前无法提供

眼动追踪、手势识别、头部追踪都需要实时计算,且需要的算力无法满足。

七、思考:什么是好的多模态交互?

我认为好的多模态交互首先要满足智能座舱的安全,再在此基础上让交互变得更舒适和高效,符合人体自然的使用习惯和感知需求,比如主动调节驾驶坐姿、 温度让驾驶者和乘坐者获得最舒适的驾乘体验,人的视线可以自然看到信息而不需要低头,手可以触碰到操作功能而不需要弯腰等等。未来智能座舱的交互系统会更加智能化、理解用户意图,汽车将成为更好的生活空间。

(以上内容仅用于学习交流讨论)

【1】谭浩, 谭征宇, 景春晖. 汽车人机交互界面设计[M]. 北京: 电子工业出版社, 2015.

TAN Hao, TAN Zheng-yu, JING Chun-hui. Automo- tive HMI Design[M]. Beijing: Electronic Industry Press, 2015.

【2】黄超俊. 智能座舱开发中的人机与交互布置研究沙龙.

【3】王建民, 刘宇佳,李阳,由芳. 基于态势感知的汽车人机界面设计研究, 2021.

https://www.researchgate.net/publication/350871476_jiyutaishiganzhideqicherenjijiemianshejiyanjiu_wangjianmin

【4】车载多模交互设计 https://zhuanlan.zhihu.com/p/172438084

【5】薛志荣. 智能座舱多模交互体验设计沙龙

本文由 @老虫的设计唠嗑 原创发布于人人都是产品经理,未经许可,禁止转载

题图来自 Unsplash,基于 CC0 协议。

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

来源:https://www.woshipm.com/ucd/5643253.html

本站部分图文来源于网络,如有侵权请联系删除。

百木园

百木园